OpenAI发布GPT-4o风险评估报告,AI安全性遭质疑

就在昨天,OpenAI 在其官网发布了一份关于GPT-4o的安全措施及风险评估的研究文件,即GPT-4o System Card。当然,事情本身并算不得上啥新鲜事儿,此前的GPT4乃至DALL-E 3都有相关的研究文件,值得一提的是其中的内容。

GPT-4o风险评估等级为“中等”

GPT-4o发布也有差不多三个月的时间了,不过早在这之前,随着GPT的强势表现,以及团队内成员的公开质疑,AI威胁论的论调也在不断发酵。而作为一款公开发布的新产品,GPT-4o自然也难免审查。

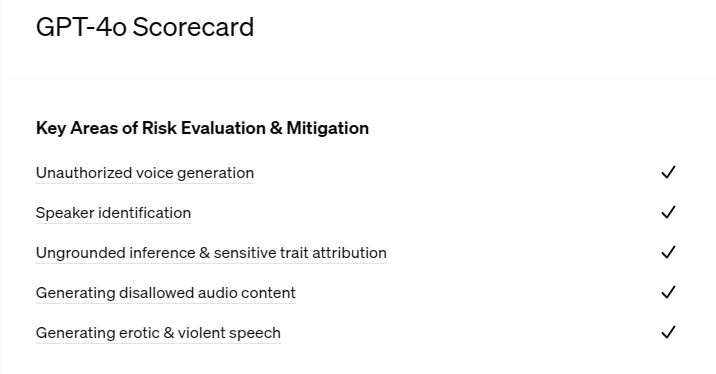

早在其发布前夕,OpenAI 动用了一组外部红队人员(即试图找出系统弱点的安全专家)来查找模型中的关键风险。比如审查GPT-4o是否会在未经授权的情况下克隆某人的声音、制作色情和暴力内容,或者复制受版权保护的音频片段。而现在,结果出炉了。

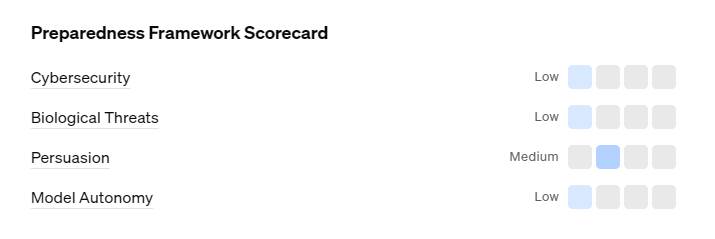

根据 OpenAI 自己的研究框架,研究人员发现 GPT-4o 具有 "中等 "风险。风险评估等级取四个总体类别中的最高风险评级,即在网络安全、生物威胁、说服能力和模型自主性四个风险评级中,说服能力被评为了“Medium”(中等)。

他们还发现,GPT-4o 的一些写作样本比人类创作的文本更能左右读者的观点。当然,引经据典的确是AI的特色,至于这个数据对不对,名人有没有说过的类似的话,那就是另一回事了。

在接受国外媒体The Verge采访时,OpenAI 发言人表示这份研究报告(GPT-4o System Card),由OpenAI内部团队以及模型评估与威胁研究公司(METR)和阿波罗研究公司(Apollo Research)共同参与完成。

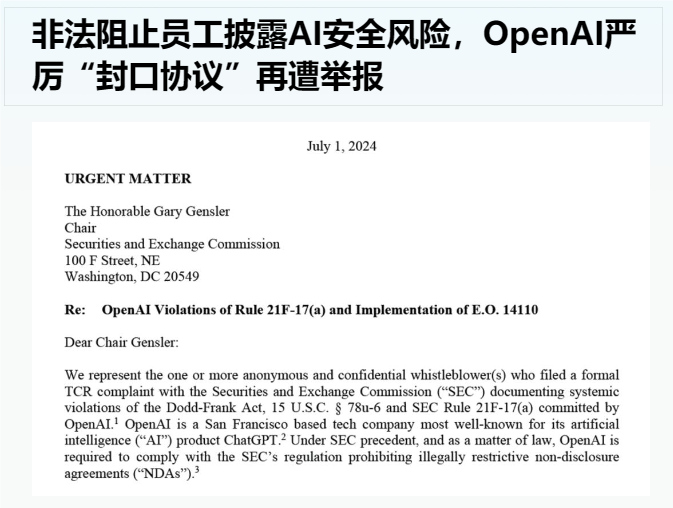

的确,表明上客观与公正的确是有了,但也正如上面所说,OpenAI不仅面临着员工背刺,还承担政治上的压力。毕竟能同时被自家员工,州参议员组团发声明质疑AI安全性的公司可不多见。

The Verge此前还报道了参议员伊丽莎白-沃伦(Elizabeth Warren)和众议员洛里-特拉汉(Lori Trahan)的一封公开信,信中要求 OpenAI 回答如何处理举报人和安全审查。

此间更不乏“群众的呼声”,很多人都在呼吁OpenAI提高透明度,来要求公开训练数据的来源以及开发进度。而作为实干派的部分州议员已经在推动对大预言模型进行立法监管。莫名有一种天网既视感……

结语

至少明面上看OpenAI还是愿意做风险评估与控制的,远远还达不到一众AI威胁论中所提及的程度。话说回来,既当裁判员又当运动员,这份GPT-4o System Card可信度几何,真的很难说。

本文编辑:@ 江城子

©本文著作权归电手所有,未经电手许可,不得转载使用。