ChatRTX介绍,系统要求与下载分享,能用但不够好用

五一期间,NVIDIA可同样没闲着,倒不是说他又出了啥新卡,而是整了个新活儿——推出了一款可以本地运行的AI工具。大家可能也有所印象,不过并不是今年2月发布的Chat with RTX,而是它的“全新升级版”ChatRTX。

NVIDIA ChatRTX是什么?

和其它GPT不同,ChatRTX是一款经过客制化的可以在本地运行的大语言模型(LLM),可以根据用户选择“连接”电脑中的部分内容(如图片、文档、笔记以及其它数据),再结合检索增强生成技术(RAG)、TensorRT-LLM与RTX加速,实现基于本地资源的问答与帮助。

作为一款本地AI工具,ChatRTX最大的优势莫过于隐私安全性更高,不过,相较于其它在线GPT的稳定输出,它的性能高低完全取决于你显卡的“强度”。此外,虽然它叫ChatRTX,实际上也并非所有的RTX显卡都能用,起码得RTX 3060往上的水平才可一战。

ChatRTX下载地址: https://www.nvidia.com/zh-tw/ai-on-rtx/chat-with-rtx-generative-ai/

NVIDIA ChatRTX 与Chat with RTX

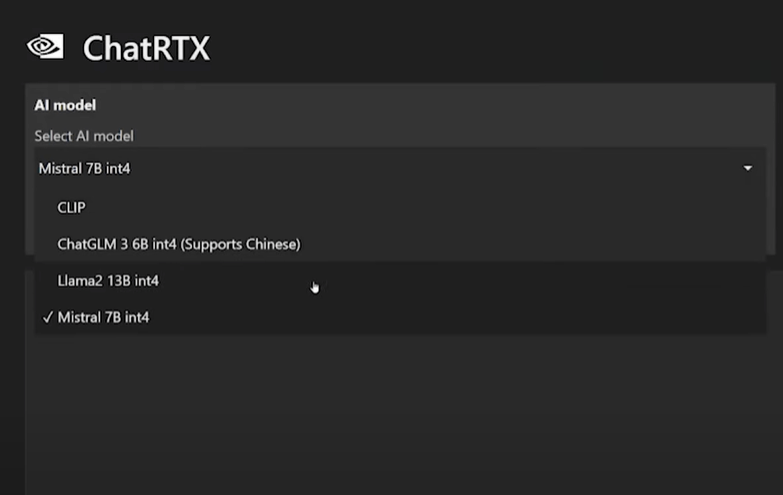

NVIDIA ChatRTX作为Chat with RTX的全新升级版,首先自然是改进了稳定性;其二就是对依赖的大语言模型进行了大幅度的更新,并增加了对其它大预言模型的支持。新增大预言模型甚至包括和谷歌Gemini同根同源的本地LLM:Gemma。

此外,由于集成了 OpenAI 的 CLIP,ChatRTX的图像识别能力也获得大幅度的升级,无需元数据就能与图像库进行交互。当然,对于国内用户来说,对中文的支持才是关键,好消息是由于ChatGLM3的更新,ChatRTX将支持中/英双语提示。最后,就是支持语音输入。

NVIDIA ChatRTX的不足之处

与之前技术演示时的 Chat with RTX一样,ChatRTX同样允许用户自由选择AI模型,以及选择自己所要操作的“数据”。简单说来就是我们可以选择一个包含图像/文档/其它支持格式的文件夹,然后ChatRTX就可以根据该文件夹内容开始学习,并根据用户需要输出结果。

不过,理想虽如此,但实际却仍让人稍有失望。NVIDIA ChatRTX的不足之处尤为明显,上下文能力的不足,让问答的连贯性出现了明显的问题;此外,牛头不对马嘴的情况也时有发生。目前浏览器的前端支持也仅仅包括Chrome和Edge,其它浏览器包括火狐都存在明显的问题。

结语

相较于其它在线AI工具而言,NVIDIA ChatRTX在功能性方面肯定是远远不如的,不过更强的隐私安全性也足以成为不少朋友选择它的理由。总之,本地大语言模型还是有很长的路要走的。

本文编辑:@ 江城子

©本文著作权归电手所有,未经电手许可,不得转载使用。